Interfaces sonores homme-machine :

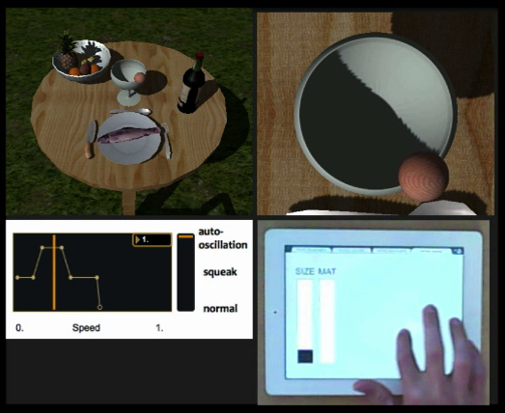

Les nouvelles technologies embarquées, par exemple dans les automobiles, sont de plus en plus coûteuses en ressources cognitives attentionnelles en particulier visuelles. De ce fait, la réflexion autour du développement de nouveaux outils alternatifs, faisant appel à un autre canal sensoriel comme l’ouïe, apparait complètement nécessaire. Afin d’aider les utilisateurs dans leurs usages d’interface virtuelle (par la reconnaissance du geste) ou d’interface tactile déportée (donc utilisée en aveugle), le son peut être à la fois une aide à l’apprentissage et un feedback d’accompagnement et de confirmation de commande.

L’utilisation de ces interfaces sera ainsi plus simple, plus intuitive et moins dangereuse durant d’autres tâches cognitives. L’approche méthodologique développée dans l’axe permettra de prendre en compte l’aspect ergonomique et esthétique dans le processus de design des sons. L’enjeu est d’aboutir à des démonstrateurs (prototypes interactifs) utilisant ces nouvelles interfaces qui s’appuieront sur des cas d’usages classiques ou plus innovants de systèmes automobiles tels que les interactions conducteur (GPS, media, téléphonie, etc.) et les interactions passagers (media, ludique).

Sonification pour l’apprentissage de gestes :

Nous cherchons ici à étudier l’influence des attributs morphologiques du son sur le mouvement humain. Il s’agit de déterminer comment la manipulation des attributs fondamentaux du son permet d’une part d’évoquer du mouvement et d’autre part d’informer mais également de guider une personne. Pour cela, nous partons du constat que pour de nombreuses applications impliquant des systèmes dynamiques en interaction avec l’homme, il est possible de poser le problème de manière à considérer l’interaction comme le guidage perceptif vers une cible.

A partir de ce postulat, il est possible de définir différentes situations de guidage et de les étudier indépendamment du contexte de l’application ceci afin de mettre en place et d’évaluer une taxonomie de la sonification basée sur des attributs fondamentaux du son perçu. Cette approche novatrice se positionne en rupture avec les travaux classiques menés en sonification en prenant en compte l’existence de la boucle perception-action. Elle permet d’adopter une approche centrée sur l’utilisateur et sa perception des informations sonores dans le cadre d’une tâche de guidage donnée plutôt que sur l’évaluation du design de sons spécifiquement conçus pour une application donnée.

Ces travaux trouvent de nombreuses applications industrielles et sociétales. Dans certains sports par exemple, l’activité visuelle est fortement sollicitée et par conséquent le canal auditif est souvent libre, permettant de transmettre des informations utiles au perfectionnement du sportif. Des travaux en cours sur le cyclisme montrent une amélioration de la technique de pédalage lorsque l’information de puissance sur la pédale est transmise au cycliste.

Synthèse de signaux audio-haptiques pour le guidage du geste :

Ce projet combine les compétences en synthèse de signaux réalistes pour le guidage du geste du laboratoire ainsi que les récents développement dans les surfaces haptiques par lévitation ultrasonore partielle effectuées dans l’équipe Biorobotique de l’Institut des Sciences du Mouvement (ISM) avec l’expertise du Service de Comportement et Facteurs Humains (SCFH) du Groupe Stellantis pour étudier des méthodes de synthèse audio-haptique sur des interfaces multimodales comportant non seulement un écran tactile mais également une stimulation acoustique et un retour haptique (i.e. qui stimule le sens du toucher). Le contact entre les doigts et l’environnement génère des vibrations complexes qui sont perçues par l’ouïe et le toucher.

Cette perception multimodale est cruciale pour le guidage de nos gestes et la manipulation précise. Ce projet, axé autour d’études phénoménologiques et psychophysiques, permettra l’identification d’invariants perceptuels qui captureront les événements mécaniques qui mènent à une perception consciente de cet environnement. Ce travail explorera de nouvelles méthodes pour produire des sensations virtuelles de matériaux et ainsi permettre leur utilisation dans le guidage du geste de l’utilisateur.

Jeu instrumental du musicien :

Nous souhaitons aborder l’interaction musicien/instrument dans son aspect le plus large en analysant les relations entre posture, geste musical, interprétation et timbre en situation de jeu chez des violoncellistes professionnels. En particulier, la relation entre le retour sonore et le geste musical sera étudiée grâce à un protocole expérimental basé sur une distorsion contrôlée des relations geste/son. Il s’agira ici, de développer un modèle de synthèse pour la production de sons de violoncelle, puis de contrôler ce modèle à l’aide d’un instrument équipé de capteurs. Ce dispositif permettra d’étudier les gestes de l’instrumentiste en fonction du retour sonore perçu (cohérent ou non avec le retour attendu) et in fine de proposer de nouveaux modes de jeu instrumental (nouvelles interfaces, nouvelles ergonomies, etc.) nécessitant une mise en correspondance ciblée entre les paramètres de synthèse et le geste de l’instrumentiste.

Ce travail permettra également d’envisager le développement d’une plateforme pédagogique autour de la pratique musicale afin d’identifier les risques encourues par des violoncellistes lorsqu’ils pratiquent leurs instrument et de proposer un retour multisensoriel sur la qualité de leurs pratiques pour les aider à optimiser leurs mouvements. Pour mener à bien ce travail, des collaborations sont envisagées avec l’équipe Expression de l’Institut de Recherche en Informatique et Systèmes Aléatoires (IRISA), Brest, spécialisée dans l’analyse et la synthèse du geste humain, le Groupe de Recherche en Sciences pour l’Ingénieur (GRESPI), l’université de Reims, spécialisé dans les interactions structure/environnement, la clinique du musicien à Paris et l’Institut d’Enseignement Supérieur de la Musique (IESM) à Aix-en-Provence.